Pochi giorni fa, a Strasburgo, il Parlamento Europeo ha approvato l’Artificial Intelligence Act (AI Act), il nuovo regolamento riguardante le intelligenze artificiali, accolta con 499 voti favorevoli, 28 contrari, e 93 astenuti.

Fra le proposte: l’istituzione di quattro livelli di rischio, il divieto per l’utilizzo di sistemi di Intelligenza artificiale per la sorveglianza biometrica nei luoghi pubblici e per la polizia predittiva. Sotto regolamentazione anche ChatGpt, con l’obbligo di dichiarare se un contenuto è stato generato dall’AI.

Intelligenze artificiali: standard Europei

Fra gli obiettivi prioritari che l’UE ha voluto assicurare fanno riferimento agli standard che i sistemi di intelligenza artificiale devono sottostare in termini di sicurezza, trasparenza, tracciabilità, soprattutto non discriminatori e rispettosi dell’ambiente. Il suo utilizzo sotto stretta supervisione degli esseri umani, per evitare conseguenze irreversibili.

Si è discusso tanto di regolamentare anche dei metodi d’utilizzo dell’intelligenza artificiale per combattere la discriminazione digitale, prevenendo la disinformazione e limitando l’utilizzo di deepfake: una tecnica basata su machine learning che permette di manipolare immagini al computer, spesso impiegata nella creazione di fake news.

“Un primo passo verso il futuro”, come afferma il Presidente di PTP Privacy Tech Professionals Rocco Panetta:

“Si tratta di una prima regolamentazione sull’intelligenza artificiale, una regolamentazione che copra da qui in avanti tutto quello che l’AI potrà anche generare e produrre, ma è parzialmente vero che sia la prima perché al momento non siamo senza rete. Abbiamo infatti già una o più regolamentazioni in grado di disciplinare l’intelligenza artificiale a partire dal GDPR e tutte le norme collegate”.

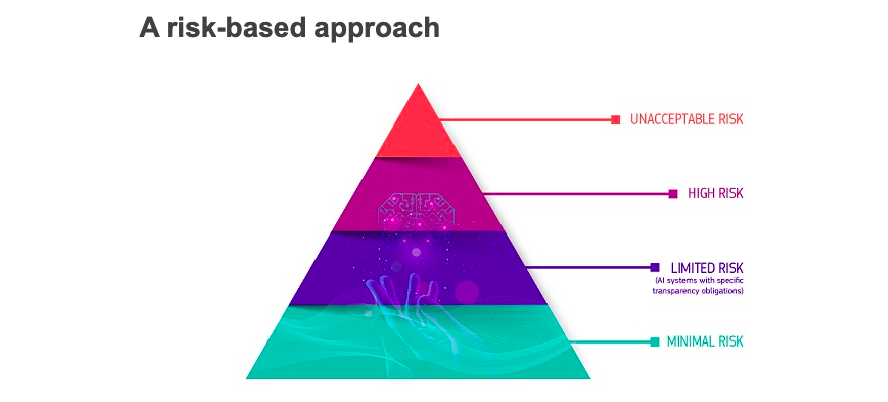

I quattro livelli di rischio delle intelligenze artificali

I fornitori e coloro che utilizzano i sistemi IA, nelle loro attività, devono prendere in considerazione un nuovo approccio basato sul rischio che può generare. Vietati, quindi, quei sistemi di IA con un livello di rischio inaccettabile per la sicurezza delle persone.

-

Rischio inaccettabile

Quei sistemi considerati una minaccia per le persone e, quindi, vietati. Sono inclusi:

- Manipolazione cognitivo-comportamentale di persone o specifici gruppi vulnerabili

- Punteggio sociale: classificare le persone in base al comportamento, allo stato socio-economico o alle caratteristiche personali

- Sistemi di identificazione biometrica remota e in tempo reale

-

Rischio alto

Quei sistemi che incidono negativamente sulla sicurezza o sui diritti fondamentali. Sono divisi in:

- Sistemi di intelligenze artificiali utilizzati nei prodotti soggetti alla legislazione dell’UE sulla sicurezza dei prodotti.

- Sistemi di AI che rientrano in otto aree specifiche che dovranno essere registrate in una banca dati dell’UE:

- Identificazione biometrica e categorizzazione delle persone fisiche

- Gestione e funzionamento delle infrastrutture critiche

- Istruzione e formazione professionale

- Occupazione, gestione dei lavoratori e accesso al lavoro autonomo

- Accesso e fruizione dei servizi privati essenziali e dei servizi e benefici pubblici

- Applicazione della legge

- Migrazione, asilo e gestione dei controlli alle frontiere

- Assistenza nell’interpretazione giuridica e nell’applicazione della legge.

Tutti i sistemi di Intelligenza Artificiale ad alto rischio saranno valutati prima di essere immessi sul mercato e anche durante il loro ciclo di vita.

-

Rischio limitato

I sistemi di Intelligenza Artificiale che comportano un rischio limitato dovrebbero comunque rispettare requisiti minimi di trasparenza che consentiranno agli utenti di prendere decisioni informate. Dopo aver interagito con le applicazioni, l’utente potrà quindi decidere se desidera continuare a utilizzarle.

Gli utenti dovrebbero essere informati quando interagiscono con l’IA, includendo, quindi, i sistemi di intelligenza artificiale che generano o manipolano contenuti di immagini, audio o video.

-

Rischio minimo

I sistemi IA che prevedono un rischio minimo non sono del tutto regolamentati, ma dovranno osservare obbligatoriamente i principi di trasparenza, di privacy e data protection. Sebbene molti sistemi di intelligenza artificiale comportino un rischio minimo, dovranno essere comunque valutati.

I divieti agli usi e abusi di ChatGPT

Tra gli articoli del regolamento, il Parlamento Ue ha promosso il divieto tassativo all’uso intrusivo e discriminatorio dell’intelligenza artificiale: tra questi, i sistemi di identificazione biometrica remota “in tempo reale” e “a posteriori” negli spazi pubblici e il cosiddetto “scraping“, ovvero l’estrazione non mirata di dati biometrici da Internet o da filmati di telecamere a circuito chiuso per creare database di riconoscimento facciale basati su caratteristiche sensibili (il genere, l’etnia, la religione e l’orientamento politico).

Non solo: il testo respinge anche i sistemi di polizia predittiva, fondati su profilazione, ubicazione o comportamenti criminali passati, e i programmi di riconoscimento delle emozioni sfruttati dalle forze dell’ordine nei luoghi di lavoro, negli istituti d’istruzione e alle frontiere.

In questa prospettiva, per promuovere l’innovazione dell’AI e sostenere le piccole e medie imprese, i deputati hanno aggiunto delle esenzioni per le attività di ricerca e i componenti dell’AI forniti con licenze open source, a codice sorgente aperto. Vengono ulteriormente promossi i cosiddetti sandbox normativi, o ambienti di vita reale, istituiti dalle autorità pubbliche per testare l’intelligenza artificiale prima che venga implementata.

In materia di ChatGPT, i parlamentari puntano a rafforzare il diritto dei cittadini di presentare reclami sui sistemi di intelligenze artificiali e ricevere spiegazioni delle decisioni basate su sistemi ad alto rischio che incidono in modo significativo sui loro diritti fondamentali. Riformato anche il ruolo dell’Ufficio AI dell’Ue, che avrà il compito di monitorare l’attuazione del regolamento sull’AI.

Il regolamento specifica che il sistema di AI generativa dovrà rispettare i requisiti di trasparenza: per farlo, sono tenuti a rendere noto tramite una dichiarazione che “i contenuti sono stati generati dall’IA”. Questo permetterà di distinguere le immagini deepfake da quelle reali, contrastando anche la produzione e diffusione di contenuti illegali.

Victoria Calvo

UniVersoMe Testata Multiforme degli Studenti UNIME

UniVersoMe Testata Multiforme degli Studenti UNIME